"Foundation Models in Robotics: Applications, Challenges, and the Future"라는 논문을 통해, 거대 언어 모델(LLM)과 비전-언어 모델(VLM)이 로봇 기술에 어떻게 접목되고 있는지, 알아보자

[논문 리뷰] Foundation Models in Robotics: Applications, Challenges, and the Future

이 리뷰는 오직 학습과 참고 목적으로 작성되었으며, 해당 논문을 통해 얻은 통찰력과 지식을 공유하고자 하는 의도에서 작성된 것입니다. 본 리뷰를 통해 수익을 창출하는 것이 아니라, 제 학

c0mputermaster.tistory.com

https://www.youtube.com/live/fnf5WEspa6Q?si=f4mpwSaGsJFKLE99

젠슨 황의 기조연설 이후, 로봇 분야에서 Physical AI라는 키워드로 물리 환경과 상호 작용하는 AI에 대한 관심이 상당히 뜨거워지고 있다고 한다.

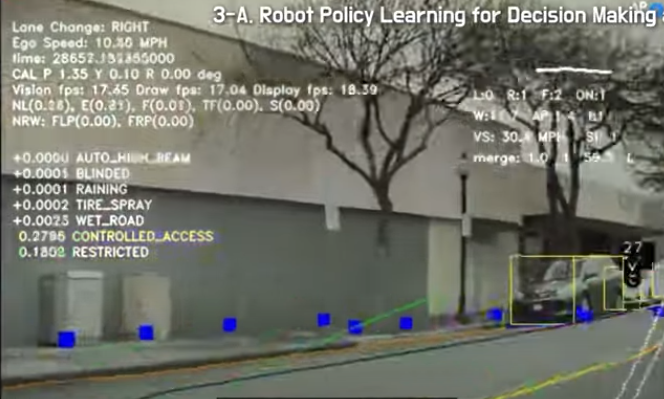

로봇 정책 학습

(Robot Policy Learning for Decision Making and Control)

첫번째 키워드는 로봇 정책 학습이다. 정책 학습은 로봇이 주어진 환경에서 적절한 행동을 선택하는 과정이다.

모방학습

모방학습이란 사람이 시범을 보이면 로봇이 그대로 따라하는 학습 방법이다. 하지만 모방학습에서에는 문제가 2개있다.

1. 데이터를 만들기 어렵고 비효율적임

로봇을 학습하기 위해서는 수만개의 데이터가 필요한데 사람이 이를 하나씩 일일이 보여 줄 수 없음

2. 닫힌 루프 문제

로봇이 학습한 범위를 벗어나면 엉뚱한 행동을 할 수 있음, 예를들어 학습된 환경에 상자가 조금 뒤틀어져 있거나 환경이 바뀌면 로봇이 이를 인지할 능력이 없어 그냥 학습한대로 수행을 함

이를 최근 로보틱스 분야에서는 대형 학습모델( Foundation )을 통해 해결하려고자 한다. CLIport는 언어와 이미지를 이용한다거나, PerAct 라는 모델은 3D 이미지를 학습하여 로봇이 더 유연하게 문제를 해결하게 만들어 주었다.

강화학습

강화학습이란 로봇이 스스로 환경을 탐색하며 최적의 행동을 찾아내는 방법이다.

로봇이 어떤 행동을 하면 보상을 받거나 벌칙을 받거나 하면서 배워가는 것이다. 예를 들어서 자율주행차가 스스로 도로를 달리는 장면을 떠올려 보면, 신호등이 빨간 불이면 멈추고 초록 불이면 출발하는 식으로 학습한다. 이때 만약 보행자를 감지하지 못하고 그냥 달려 버린다면 벌점을 받게 된다.

이렇게 시행착오를 거치면서 점점 더 정확한 운전을 배우게 되는 것이다. 하지만 이런 강화 학습에도 문제가 있다. 첫 번째, 환경을 탐색하는 데 너무 많은 시간이 걸린다는 것, 두 번째, 새로운 상황에서 학습을 처음부터 다시 해야 한다는 점이다.

그래서 이에 대한 해결책으로 최근 연구들은 대형 언어 모델과 비전 언어 모델을 강화 학습에 결합해서 이 문제를 해결하고 있다. 그 예로 이 논문에서 몇 가지 모델을 소개하고 있는데, 첫 번째, 세이켄 로봇이 언어 모델을 활용해 태스크를 분해하고 할 수 있는 것과 없는 것을 구별하는 모델이고. 다음으로 팜(PaLM)은 이미지와 언어를 함께 이해하는 모델로, 새로운 환경에서도 빠르게 적응한다는 장점을 가지고 있는 모델이다.

가치 학습

로봇이 언어와 시각 정보를 활용해 목포를 스스로 이해하고 그에 맞춰 움직이는 것을 가치 학습이라고 한다.

쉽게 말하면 로봇이 주어진 목표를 달성하기 위해서 어떤 행동을 해야하는지 평가하는 과정이다. 이미지나 언어로 주어진 목표를 해석하고 그에 맞는 행동을 결정한다. 컵을 테이블 위치에 올려놔 라고 하면 이미지로 테이블의 위치를 확인하고 컵을 집어서 그곳으로 옮기는 방법을 학습한다.

- 논문에서 소개하는 세 가지 가치 학습 모델:

- R3M: 인간의 작업 영상을 학습하여 로봇 조작을 위한 시각적 표현을 제공함

- VIP 모델: 영상 데이터만으로 보상을 추정하고 행동을 결정함

- Li 모델: 언어와 이미지 정보를 동시에 학습하여 목표 지향적 행동을 수행함

로봇이 혼자 생각하고 실행할 수 있을까? ( Task Planning )

로봇이 주어진 명령을 이해하고 최적의 행동을 스스로 계획하는 과정이다.

과거에는 사람이 직접 로봇의 동작을 코딩했지만, 최근에는 LLM을 활용하여 자연어로 작업을 설명하면 로봇이 행동을 계획할 수 있게 되었다. 예를 들어, "컵을 싱크대에 넣어 줘"라고 명령하면, 로봇은 컵을 인식하고 이를 잡고 이동시키는 동작을 자동으로 계획한다. 이를 가능하게 한 연구 중 하나가 구글 딥마인드의 SayCan 모델이다.

https://arxiv.org/abs/2204.01691

Do As I Can, Not As I Say: Grounding Language in Robotic Affordances

Large language models can encode a wealth of semantic knowledge about the world. Such knowledge could be extremely useful to robots aiming to act upon high-level, temporally extended instructions expressed in natural language. However, a significant weakne

arxiv.org

이 모델은 로봇이 할 수 있는 행동을 LLM을 통해 결정합니다. Say 단계에서는 명령을 분석하고 태스크를 세분화하며, Can 단계에서는 로봇이 실제 환경에서 해당 행동을 실행 가능한지 판단한다. 예를 들어, "음료수를 테이블로 가져다 줘"라는 명령을 받으면, Say 단계에서는 음료수를 찾고 집어서 옮기는 동작을 계획하고, Can 단계에서는 테이블이 너무 높아 해당 작업이 불가능하다면 대안을 찾도록 돕는다. 즉, 로봇은 LLM을 통해 명령을 분석하고, 실제 환경에서 행동을 계획하며, 실행 가능성을 고려하여 태스크를 최적화할 수 있다.

추가적으로 자동 태스크 변환이라는 작업을 통해서 자연어를 논리적 명령어로 변환 과정을 거치게 된다. LLM이 자연어를 받아서 로봇이 이해할 수 있는 논리적인 명령어로 변환하는 기술이다. 예를 들어, 자연어 시간 논리 변환 (TL, Temporal Logic) 연구에서는 로봇이 일정한 순서대로 작업을 수행하도록 2,000개의 자연어 논리적 명령어 데이터를 학습하여 자연어를 더 논리적인 명령어로 변환하는 기술을 만들었다. 예를 들어, "방을 치워 줘"라는 명령이 입력되면 언어 모델이 해당 명령을 "먼지를 쓸고, 쓰레기를 버리고, 물건을 정리하는" 단계로 변환하는 것이다.

자연어만으로 로봇을 움직일 수 있을까?

자연어만으로 로봇을 움직일 수 있을까? 기존의 로봇 제어 방식은 로봇을 동작시키려면 하나하나 직접 코드를 작성해야 했고, 상황에 맞는 행동을 룰 베이스로 정의해야 했다. 하지만 이제는 LLM을 활용하여 자연어로 설명만 하면, LLM이 자동으로 코드를 생성하고 실행할 수 있게 된 것이다.

먼저, 프로그 프롬프트는 LLM이 태스크 수행을 위한 명령어 시퀀스를 자동으로 생성하는 방법이다. 이 연구에서는 사람이 미리 정의한 프로그램 없이 자연어 명령만으로 작업을 분해하고 실행하는 방식이 실험되었다. 예를 들어, "요리를 해 줘"라고 말하면 LLM이 "냉장고 열기, 재료 꺼내기, 조리대에 두기"와 같은 순서로 명령을 변환하는 방식이다.

https://arxiv.org/abs/2209.11302

ProgPrompt: Generating Situated Robot Task Plans using Large Language Models

Task planning can require defining myriad domain knowledge about the world in which a robot needs to act. To ameliorate that effort, large language models (LLMs) can be used to score potential next actions during task planning, and even generate action seq

arxiv.org

다음으로 code as policies는 LLM이 직접 로봇 제어 코드를 생성하는 방법이다. LLM이 자연어 명령을 코드로 변환하여 실행할 수 있도록 돕는 연구이다. 예를 들어, "이 컵을 10cm 왼쪽으로 옮겨 줘"라고 하면, LLM은 이를 파이썬 코드로 변환하여 실행할 수 있는 코드로 만들어 로봇이 해당 작업을 자동으로 수행하게 된다.

이러한 방식들은 LLM이 로봇 제어에 필요한 코드를 생성하고, 로봇이 이를 실행하게 만들어, 코딩 없이도 자연어로 로봇을 제어할 수 있게 하는 것이다.

https://velog.io/@jk01019/Code-as-Policies-Language-Model-Programs-for-Embodied-Control

Code as Policies: Language Model Programs for Embodied Control

대형 언어 모델(LLM)은 코드 완성을 위해 학습된 경우, 도큐먼트 스트링에서 간단한 파이썬 프로그램을 생성할 수 있는 능력을 갖추고 있음을 보여주었다 1. 우리는 코드 작성 LLM이 -> 자연어 명령

velog.io

로보틱스속 In-context Learning

인컨텍스트 학습 (ICL, in-context Learning) : 기존 머신러닝 모델은 추가 학습이 필요하지만, 인컨텍스트 학습은 주어진 예제만으로 즉시 학습하고 의사 결정을 내림

https://velog.io/@hundredeuk2/In-context-Leaning

In-context Leaning이란?

정확한 정의 : 사전 학습과 미세 조정을 결합하는 동시에 학습 프로세스 중에 작업별 지침이나 프롬프트를 통합하는 새로운 접근 방식입니다. 모델은 주어진 지침에 따라 상황에 맞는 응답 또는

velog.io

Chain of Thought(COT): 복잡한 문제를 단계별로 나누어 해결하는 학습 방식, 점진적으로 학습

ICL, 즉각적인 학습을 가능하게 한다면, COT는 로봇이 더 복잡한 태스크를 수행할 수 있도록 논리를 구조화하는 방법이다. LLM과 ICL을 활용하면 로봇은 새로운 환경에서도 추가적인 학습 없이 유사한 패턴을 인식하고 최적의 행동을 수행할 수 있게 된다. 예를 들어, 로봇이 자율주행 도중 예상치 못한 장애물을 만나면, 기존 모델은 사전에 학습되지 않은 경우에 적절한 회피 행동을 하지 못했지만, ICL을 적용한 모델은 과거의 유사한 경험을 기반으로 즉시 대응할 수 있다. 즉, 로봇은 기존 데이터만으로 해결할 수 없는 문제도 새로운 환경에서 패턴을 인식하여 적절한 결정을 내릴 수 있게 되는 것이다.

Chain of Thought (COT) 관련 연구에서는 지하 연구팀이 ICL을 활용한 COT 기법을 로봇 정책 학습에 적용했다. 로봇은 작업을 수행할 때 여러 단계를 나누어 논리적으로 해결하는 방법을 학습하게 되며, 이를 통해 복잡한 물체 조작, 경로 계획 등을 더 정교하게 수행할 수 있다. 예를 들어, 로봇이 책장을 정리할 때, 바닥에 떨어진 책을 먼저 감지하고, 올바른 위치를 판단하여 정리하며, 무거운 책을 먼저 놓고 가벼운 책을 위에 배치하는 등의 행동을 할 수 있다.

이처럼 COT 기반의 ICL을 활용하면 로봇은 작업의 구조를 더 잘 이해하고, 보다 정밀하게 수행할 수 있게 된다. AI 트랜스포머 모델을 활용하면, 로봇은 더욱 향상된 패턴 인식과 문제 해결 능력을 갖추게 되어, 다양한 환경에서도 더 효율적으로 작업을 수행할 수 있을 것이다.

로봇 트랜스포머 모델

- 다섯 번째 주제는 로봇 트랜스포머 모델임

- 트랜스포머 모델은 자연어 처리에서 발전하여 이미지, 행동 데이터까지 학습하는 강력한 도구임

- RT-1, RT-2, RTX 모델 소개:

- RT-1: 로봇이 동작을 생성하는 모델

- RT-2: 웹에서 학습한 개념까지 이해하여 행동을 생성함

- RTX: 여러 로봇 데이터를 통해 학습하여 범용적으로 적용 가능함

Open Vocabulary 모델

Open-Vocabulary Object Detection via Vision and Language Knowledge Distillation 리뷰 [ICLR 2022]

이번에 리뷰할 논문은 Open-Vocabulary Object Detection이라는 task를 제안한 논문입니다. 본 논문에서는 Object Detector가 검출 가능한 객체의 종류를 늘리기 위해 학습 데이터에 포함된 객체의 종류를 늘리

skyil.tistory.com

- 로봇이 사전에 학습된 환경이 아닌 새로운 환경에서도 탐색하고 조작할 수 있도록 하는 모델임

- 최신 연구 사례:

- VLMo: 비전-언어 정보를 활용하여 새로운 환경에서도 탐색가능함

- LM-internal: 언어 기반 실외 로봇 내비게이션시스템임

Embodied AI

Embodied AI란 무엇인가?

구현하다는 뜻을 가진 Embody의 과거분사인 Embodied와 인공지능을 뜻하는 AI가 결합된 단어입니다. 시뮬레이터(Simulator)라는 3D 가상환경(Environment)에 에이전트를 생성하여 여러가지 과제(Task)를 수행

blog.mindong.uk

Embodied AI는 시뮬레이터(Simulator)라는 3D 가상환경(Environment)에 에이전트를 생성하여 여러가지 과제(Task)를 수행시켜 학습시킨 후, 현실의 로봇과 같은 기계에 전이하여(Sim2Real) 현실에서도 특정 과제(Task)를 잘 수행할 수 있도록 하는 분야이다.

인바디드 AI와 에이전트 행동 계획

- 대규모 언어 모델( LLM)이 가상 환경에서 에이전트의 행동 계획에 어떻게 적용되는지를 다룸

- LLM의 인 컨텍스트 학습능력은 에이전트가 새로운 태스크를 수행하는 데 도움을 줌

에이전트의 기억 시스템

- 에이전트는 두 개의 LLM을 사용하여 환경을 이해하고 기억을 업데이트함

- 이는 게임에서의 기록처럼 에이전트가 긴 시간 동안의 상황 변화를 인지하고 계획을 수정할 수 있게 함

에이전트란?

AI 에이전트(AI Agents)는 사용자의 개입 없이 자율적으로 작동하며, 환경을 인지하고 학습하여 주어진 목표를 달성하거나 문제를 해결하는 지능형 소프트웨어 시스템임

에이전트의 행동 결정 과정

- 플래너는 행동 지시

- 액터는 실제 행동을 수행

- 리포터는 행동 결과를 피드백하여 플래너에 전달

Ego 와 Embodied GPT

- EgoCOT 데이터셋은 실제 작업을 수행하는 사람들의 비디오와 언어 지시문을 포함

- Embodied GPT는 기존 언어 모델에 추가 모듈을 더하여 특정 태스크에 맞게 출력을 조정함

Generative Agents

https://insoo-hwang.tistory.com/28

[논문 리뷰] Generative Agents: Interactive Simulacra of Human Behavior

HTML 삽입 미리보기할 수 없는 소스 [원문] [데모] [코드] 이 논문에서는 인간처럼 행동하는 AI 캐릭터들을 시뮬레이션 한 내용에 관해 서술합니다. 이 시뮬레이션에 사용된 아키텍처는 대규모 언

insoo-hwang.tistory.com

이 논문에서는 '생성 에이전트(Generative Agents)'라는 개념을 소개한다. 생성 에이전트는 언어 모델을 기반으로 하여 사람의 행동을 사실적으로 시뮬레이션하는 컴퓨터 소프트웨어 에이전트이다. 이를 통해 몰입형 환경, 대인관계 의사소통 연습, 프로토타입 도구 등의 상호작용형 애플리케이션을 구현할 수 있다. 저자들은 이 에이전트가 자신의 경험을 자연어로 기록하고, 반성하며, 행동을 계획하는 메커니즘을 설명한다.

로보틱스에서 Generative 시뮬레이터는 다양한 환경에서 여러 작업을 수행할 수 있는 범용 로봇을 목표로 한다. 실제 환경에서 로봇을 훈련하는 대신, 다양한 가상 환경과 시나리오를 만들어 로봇이 다양한 상황을 학습할 수 있게 하는 시뮬레이터이다. 이를 통해 시간과 비용을 절감하고 안전 문제를 해결할 수 있다. Generative Agents를 통해 로봇이나 소프트웨어 에이전트가 실제 사람처럼 행동하고 상호작용할 수 있도록 훈련한다.

결론

오늘은 "Foundation Models in Robotics" 논문에서 로보틱스에 관한 내용을 정리해보았다. 로봇 AI의 발전이 빠르게 이루어지고 있으며, 앞으로의 변화에 대한 기대가 크고 유익한 논문을 리뷰해보았다고 생각했다.

https://arxiv.org/abs/2312.07843

Foundation Models in Robotics: Applications, Challenges, and the Future

We survey applications of pretrained foundation models in robotics. Traditional deep learning models in robotics are trained on small datasets tailored for specific tasks, which limits their adaptability across diverse applications. In contrast, foundation

arxiv.org

'Robotics > Basic' 카테고리의 다른 글

| [Deep Learning] PaLM-SayCan 모델 알아보기 (0) | 2025.04.13 |

|---|