이 리뷰는 오직 학습과 참고 목적으로 작성되었으며, 해당 논문을 통해 얻은 통찰력과 지식을 공유하고자 하는 의도에서 작성된 것입니다. 본 리뷰를 통해 수익을 창출하는 것이 아니라, 제 학습과 연구를 위한 공부의 일환으로 작성되었음을 미리 알려드립니다.

이 논문은 24년 6월에 게재된 논문으로 로보틱스에서 LLM을 이용한 논문을 찾던중 흥미로워서 리뷰하게 되었다.

H. Liu, Y. Zhu, K. Kato, A. Tsukahara, I. Kondo, T. Aoyama, and Y. Hasegawa, "Enhancing the LLM-Based Robot Manipulation Through Human-Robot Collaboration," IEEE Robotics and Automation Letters, vol. 9, no. 8, pp. 6904–6911, Aug. 2024, doi: 10.1109/lra.2024.3415931.

Abstract

대형 언어 모델(LLM)은 로봇 공학 분야에서 인기를 얻고 있습니다. 그러나 LLM 기반 로봇은 언어 모델, 로봇 및 환경 간의 통합이 부족하여 단순하고 반복적인 동작에만 제한됩니다. 본 논문은 인간-로봇 협력(HRC)을 통해 LLM 기반 자율 조작의 성능을 향상시키는 새로운 접근 방식을 제안합니다. 이 접근 방식은 높은 수준의 언어 명령을 로봇이 실행할 수 있는 동작 시퀀스로 분해하는 GPT-4 언어 모델을 사용하는 방법을 포함합니다. 시스템은 또한 YOLO 기반의 인식 알고리즘을 사용하여 LLM에 시각적 힌트를 제공하고, 이를 통해 특정 환경 내에서 실현 가능한 동작을 계획하는 데 도움을 줍니다.

또한, 동적 움직임 원시(DMP)를 이용한 원격 조작과 결합하여 LLM 기반 로봇이 인간의 지도로부터 학습할 수 있도록 하는 HRC 방법을 제안합니다. 실제 실험은 Toyota Human Support Robot을 사용하여 조작 작업을 수행했습니다. 실험 결과, 인간 시연을 통합함으로써 환경에 대한 고급 추론과 복잡한 궤적 계획이 필요한 작업을 효율적으로 수행할 수 있음을 보여줍니다.

INTRODUCTION

자연어를 통해 인간과 상호작용할 수 있는 자율 로봇의 개념은 수년간 로봇 공학 연구에서 큰 관심을 끌었습니다. 최근 Transformer 기술을 기반으로 한 대형 언어 모델(LLM)의 등장으로 이 비전을 실현할 수 있는 실용적인 접근 방식이 제시되었습니다. LLM은 기계 학습에서 중요한 기술로 자리잡았으며, 특히 인간-로봇 상호작용과 작업 계획 분야에서 큰 가능성을 보여주고 있습니다.

LLM이 현실 세계의 시나리오에서 로봇의 행동을 효과적으로 안내하려면 환경 인식과의 통합이 중요합니다. 이 통합은 로봇이 사용자의 지시를 자율적으로 해석하고 행동할 수 있도록 합니다. 이를 가능하게 하는 주요 기술에는 컴퓨터 비전 알고리즘인 YOLO(You Only Look Once)와 CLIP(Contrastive Language-Image Pre-Training), SAM(Segment Anything Model) 등이 포함됩니다. LLM과 고급 컴퓨터 비전의 결합은 로봇이 사용자 명령에 따라 복잡하고 정밀한 동작을 수행할 수 있는 진보된 로봇 조작 플랫폼을 발전시키는 데 기여했습니다.

그럼에도 불구하고, LLM 기반 로봇 시스템의 기존 연구는 주로 간단하고 반복적인 작업 계획에 초점을 맞추고 있습니다. 예를 들어, 물건을 집어 놓는 작업은 잘 수행되지만, 음식을 데우거나 굽는 등 고급 추론과 궤적 계획을 요구하는 복잡한 작업은 충분히 다루어지지 않았습니다. 이러한 한계는 주로 두 가지 문제에서 발생합니다.

(i) LLM 기반 로봇 제어의 일반적인 방법은 로봇의 동작을 유도하는 코드를 생성하는 것입니다. 이 방식은 단순한 작업에는 효과적이지만 복잡한 궤적을 처리할 때는 환경에 맞게 동작 명령을 동적으로 수정할 수 있는 고급 기능이 부족하여 한계가 있습니다.

(ii) 현재 LLM 기반 인간-로봇 상호작용 프레임워크는 인간 명령이 단일 입력에 제한되는 경우가 많으며, 이는 복잡하고 동적인 현실 세계 작업에서의 지속적인 감독과 지시를 어렵게 만듭니다. 따라서 직관적이고 원활한 인간-로봇 협력(HRC)이 LLM 기반 로봇의 능력을 향상시키는 데 필수적입니다.

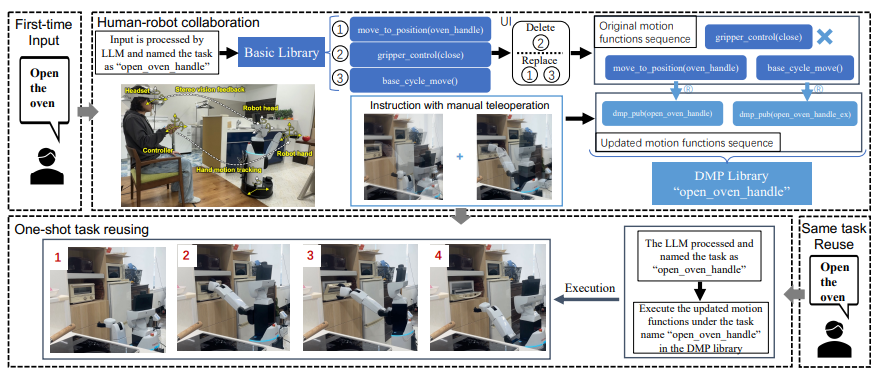

이 논문에서는 이러한 문제를 해결하기 위해 LLM 기반 로봇 조작 프레임워크와 HRC를 결합한 새로운 시스템을 제안합니다. 이 시스템은 단순한 LLM 기반 자율성을 넘어서 원격 조작 시스템을 통합하여 인간의 입력을 자율 과정에 반영할 수 있도록 합니다. 이를 통해 인간의 지도가 필요한 복잡한 작업을 수행할 수 있습니다. 또한, 동적 움직임 원시(DMP)를 사용하여 수동 원격 조작으로부터 궤적 데이터를 캡처하고 저장하여, 이를 모션 라이브러리에 추가하고 재사용할 수 있습니다. 이 시스템은 작업 특정 자율성을 촉진하고 학습 효율성을 향상시키는 데 기여합니다.

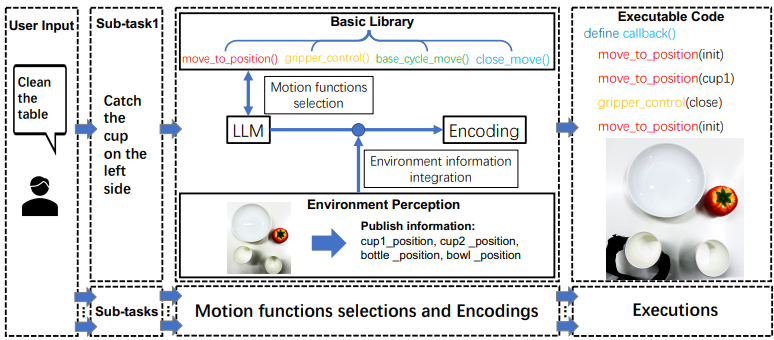

1. GPT-4 기반의 LLM 시스템을 개발하여 복잡한 장기 작업을 위한 작업 계획을 용이하게 합니다. LLM은 자연어 명령에 따라 모션 라이브러리에서 동작 함수를 선택하고, 선택된 함수는 YOLOv5 기반의 인식 모듈을 통해 환경 정보를 통합하여 다양한 작업을 자율적으로 수행할 수 있습니다.

2. 제안된 LLM 시스템은 GPT-4의 프롬프트 기능을 활용하여 계층적인 계획 프레임워크를 채택합니다. LLM은 복잡한 작업을 하위 작업으로 분해하고, 하위 작업을 여러 동작 함수로 세분화하여 순차적으로 실행합니다.

3. 원격 조작 기반의 HRC 프레임워크를 제안하여, 인간의 시연을 통해 LLM 기반 로봇이 학습할 수 있도록 하고, 이로써 동작 능력을 향상시킵니다.

4. 제안된 HRC 프레임워크는 LLM 기반 시스템의 복잡한 작업 실행 능력을 크게 향상시킵니다. 이 시스템은 복잡한 궤적 계획과 환경에 대한 추론이 필요한 작업을 인간 시연을 통해 효율적으로 수행할 수 있습니다.

METHODS

제안된 방법은 LLM(대형 언어 모델)과 ROS(로봇 운영 시스템) 내의 환경 정보를 결합하여 LLM 기반 자율 시스템을 구축하는 것입니다. LLM 기반 시스템이 복잡한 작업을 수행할 수 있는 능력을 향상시키기 위해 HRC(인간-로봇 협업) 방법을 채택하여 로봇의 동작을 인간의 시범에 따라 안내합니다. 이 통합은 인간의 명령을 특정 로봇의 동작으로 변환할 수 있게 해줍니다. 시스템은 동작 실행을 위해 두 가지 주요 라이브러리를 사용합니다: 기본 라이브러리와 DMP 라이브러리입니다.

- 기본 라이브러리: 이 라이브러리는 사전 프로그래밍된 동작 함수들을 포함하고 있습니다. LLM은 작업 요구 사항에 따라 동작 함수를 선택하고 이를 환경 정보와 결합하여 Python 코드로 생성합니다. 이 코드는 로봇이 작업에 해당하는 동작을 수행하도록 제어합니다.

- DMP 라이브러리: 이 라이브러리는 DMP(동적 이동 계획) 기술을 사용하여 개발되었으며, 하위 작업(단기 작업)에 대한 갱신된 동작 함수 시퀀스를 저장합니다. 이러한 동작 함수 시퀀스는 사용자 인터페이스를 통해 텔레오퍼레이션을 활용하여 갱신됩니다.

장기 작업을 수행하기 위해 LLM은 DMP 라이브러리에서 갱신된 한 번의 하위 작업을 추출하고 이를 기본 라이브러리의 동작 함수로 구성된 다른 제로 샷 하위 작업과 결합할 수 있습니다.

자율 로봇 조작을 위한 대형 언어 모델

우리의 방법론에서는 GPT-4 Turbo 네트워크(온도는 0으로 설정)를 사용하여 로봇 제어 허브를 구성합니다. 이 허브는 사용자의 입력을 받아 파이썬 코드로 통합할 수 있는 동작 함수로 변환하는 역할을 합니다. 모델의 출력이 특정 요구 사항을 충족하도록 하기 위해, 프롬프트를 제공하여 특별한 커스터마이징 과정을 거칩니다. LLM의 임무를 명확히 하기 위해 제공되는 프롬프트는 다음과 같습니다: “당신의 임무는 사용자가 지정한 작업을 완료하기 위해 로봇을 제어하는 것입니다. 이때 기본 라이브러리의 동작 함수를 활용하십시오.”

또한, 기본 라이브러리의 구성 요소를 소개하는 프롬프트는 다음과 같습니다:

- 'move to position()': 로봇의 엔드 이펙터를 목표 위치로 이동시키며, 역운동학 계산을 통해 조인트 각도를 업데이트합니다.

- 'base cycle move()': 로봇의 베이스를 주어진 각도와 반지름에 따라 원형으로 이동시킵니다. 이 함수는 문을 완전히 여는 동작도 포함합니다.

- 'close move()': 수직 문축을 가진 문을 닫는 데 사용됩니다. 동작 범위는 객체의 크기에 따라 결정됩니다.

- 'gripper control()': 그리퍼의 열림과 닫힘을 제어하며, 객체의 크기에 따라 열림 정도를 조정할 수 있습니다.

이러한 일반적인 프롬프트를 통해 LLM은 추가적인 관련 프롬프트 없이 유사한 작업을 일반화하고 수행할 수 있습니다. 이는 프롬프트 디자인이 중요하지만, 작업 수행에서 가장 중요한 부분은 아니며, LLM이 효과적으로 동작할 수 있도록 해줍니다.

또한, LLM이 동작 함수를 제대로 실행하도록 보장하려면, 자세한 프롬프트 제공이 중요합니다. 예를 들어, 커스터마이징 입력에는 다음과 같은 지침적 예시가 포함되어야 합니다: "사과를 접시에 놓으라고 요청하면, 'move to position(init)', 'move to position(apple)', 'gripper control(close low)', 'move to position(init)', 'move to position(plate)', 'gripper control(open)', 'move to position(-init)'와 같은 동작 함수를 정리할 수 있습니다."

명령어에서 모호성이나 불분명함을 처리하기 위해, 시스템은 추가적인 프롬프트를 통해 커스터마이징할 수 있습니다. 예를 들어, "여러 객체가 동일한 이름을 공유하는 경우, '여러 객체가 동일한 이름을 공유합니다. 어떤 것을 원하시나요?'와 같이 사용자에게 묻도록 할 수 있습니다."

이러한 커스터마이징을 기반으로, LLM은 사용자 요구에 맞게 기본 라이브러리에서 동작 함수를 선택하고 활용하여 99.4%의 실행 가능성을 달성합니다 (표 I). 또한, 시스템에서는 계층적 작업 계획 전략을 적용하여, 현실 세계에서 복잡하고 긴 시간의 작업을 처리할 수 있습니다. 예를 들어, 음식을 데우는 작업처럼 긴 시간의 작업을 처리할 때, LLM은 이를 구체적인 하위 작업으로 나누어 동작 함수로 세분화하여 실행합니다. 긴 동작 함수의 연속이 오류를 초래할 가능성이 있기 때문입니다. 다양한 작업을 분류하기 위해 제공되는 프롬프트는 다음과 같습니다: "작업을 받으면, 먼저 이 작업을 하위 작업으로 나눌 수 있는지 고려하고, 나눌 수 있으면 동작 함수와 함께 하위 작업으로 나누고, 그렇지 않으면 동작 함수를 직접 출력하십시오."

계산된 목표 위치와 동작 함수 통합

- 로봇은 목표 위치를 계산하고 이를 이름별로 레이블을 붙여 계속해서 게시합니다.

- LLM은 이러한 위치를 동작 함수와 통합하여 로봇의 움직임을 유도합니다.

두 가지 알고리즘을 통한 효율적인 작업 처리

- 알고리즘 1: YOLOv5로 감지된 동일 이름의 객체를 정렬하고 레이블을 붙여 특정 객체를 선택할 수 있게 합니다.

- 알고리즘 2: 작업 실행 전 장애물을 식별하고 이를 제거한 후, 본래의 작업을 진행합니다.

LLM의 한계와 인간-로봇 협업 필요성

- LLM은 기본적인 작업을 처리할 수 있지만, 복잡한 환경에서는 한계가 드러납니다.

- 예시로, LLM은 일반적인 전자레인지는 작동할 수 있지만, 수평 축 문을 여는 데 어려움을 겪을 수 있습니다.

- 이러한 한계를 극복하기 위해 인간이 직접 개입할 수 있는 인간-로봇 협업(Human-Robot Collaboration, HRC) 프레임워크가 필요합니다.

인간-로봇 협업을 위한 시스템

- 텔레오퍼레이션: 사용자가 로봇의 동작을 실시간으로 제어할 수 있는 시스템으로, 사용자 인터페이스(UI)와 텔레오퍼레이션 시스템을 통해 동작을 수정합니다.

- 사용자는 로봇의 동작을 텔레오퍼레이션으로 수정하고, 수정된 동작은 DMP(Dynamic Movement Primitive) 라이브러리에 저장되어 나중에 재사용됩니다.

EXPERIMENTS AND DISCUSSION

이 연구에서는 LLM(대형 언어 모델)을 기반으로 한 인간-로봇 협업(HRC) 프레임워크가 실제 환경에서 테스트된 결과를 다룹니다. 실험에 사용된 로봇은 Toyota의 Human Support Robot (HSR)로, 이 로봇은 10개의 자유도를 가지고 있으며, 3개의 자유도를 가진 모바일 베이스, 5개의 자유도를 가진 팔(4개의 회전 조인트와 1개의 상체 리프트 조인트)과 그리퍼, 2개의 자유도를 가진 머리로 구성되어 있습니다. 이 로봇은 Oculus VR 장치를 사용하여 원격 조작됩니다. 실험은 주방 환경에서 이루어졌으며, 사용자가 자연어 명령으로 로봇에게 다양한 가정용 작업을 수행하도록 지시했습니다.

로봇이 주어진 명령을 어떻게 이해하고, 실제 환경에서 작업을 얼마나 잘 수행하는지를 테스트했다는 것입니다. 예를 들어, "문 열기", "애플 데우기", "테이블 닫기" 같은 기본적인 가사 작업들이나, 좀 더 복잡한 작업들을 로봇이 잘 할 수 있는지 평가했습니다.

주요 실험 내용:

- 제로-샷 기본 작업:

- 로봇은 명령을 받으면 "문을 열기"나 "애플 데우기" 같은 작업을 할 수 있습니다. 이 작업들은 사전에 구체적인 예시를 보지 않고도 수행할 수 있는 기본적인 작업들입니다.

- 원샷 DMP 기반 작업:

- 이 작업들은 좀 더 복잡하거나, 사전 학습을 통해 특정 동작을 학습한 후 수행하는 작업들입니다. 예를 들어, 오븐 문을 여는 작업처럼 특정 동작을 로봇이 정확히 수행할 수 있도록 학습합니다.

DMP란?

실험 결과:

- 실행 가능성(Executability): 로봇이 주어진 명령대로 작업을 실행할 수 있는지 평가한 결과, 대부분의 작업이 성공적으로 실행되었고, 몇몇 복잡한 작업에서는 작은 오류가 있었음.

- 실현 가능성(Feasibility): 주어진 명령이 실제로 로봇이 할 수 있는지 여부로, 일부 작업은 협업이 없으면 불가능했으나, 인간-로봇 협업을 통해 성공적으로 수행된 경우가 많았습니다.

- 성공률(Success rate): 로봇이 실제로 작업을 완료한 비율로, 복잡한 작업에서는 성공률이 떨어졌습니다. 특히, 애플을 데우거나 굽는 작업에서 성공률이 낮았습니다.

결론:

이 연구는 LLM을 활용한 로봇의 인간-로봇 협업이 실질적으로 복잡한 작업을 수행할 수 있게 돕는 중요한 역할을 한다는 점을 보여줍니다. 또한, 로봇의 인식 오류나 제어 오류도 일부 발생했지만, 전반적으로 로봇이 다양한 작업을 성공적으로 수행할 수 있다는 것을 입증했습니다.

즉, 이 연구는 로봇이 사람의 언어 명령을 이해하고 실제로 가사나 복잡한 작업을 처리하는 능력을 평가한 결과를 설명하고 있습니다.

출처

https://arxiv.org/abs/2406.14097

Enhancing the LLM-Based Robot Manipulation Through Human-Robot Collaboration

Large Language Models (LLMs) are gaining popularity in the field of robotics. However, LLM-based robots are limited to simple, repetitive motions due to the poor integration between language models, robots, and the environment. This paper proposes a novel

arxiv.org

'Robotics > Paper reviews' 카테고리의 다른 글

| [논문 리뷰] Do As I Can, Not As I Say:Grounding Language in Robotic Affordances (saycan) (0) | 2025.04.04 |

|---|---|

| [논문 리뷰] Foundation Models in Robotics: Applications, Challenges, and the Future (0) | 2025.03.28 |